Systematisch fout

Niet enkel na het zien van de presentatie (Yt) van Snake Oil over kunstmatige intelligentie kreeg ik deze ingeving. Dat is misschien een wat sterk begrip, maar past redelijk. Iedereen probeert iets zinnig te zeggen over de golf aan mogelijkheden en ontwikkelingen die ons voorgeschoteld worden met, over en door AI.

Ai is te zien als een combinatie van voorspellen en statistiek. Het vormt ook een logisch echtpaar. Voorspellen is al een stochastisch iets en statistiek voer je uit met het oog op de toekomst.

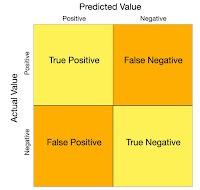

Diegenen die er in gedoken zijn, komen op een bepaald moment uit bij de matrix die de combinatie van goede en foute voorspellingen voorhoudt.

- False positives

- False negative

- True positives

- True negatives

Een bekend voorbeeld is dat een patiënt een mogelijke ziekte heeft. Dat kan na het modelleren goed uitkomen, de patiënt heeft inderdaad de ziekte, maar het kan ook een foute diagnose omvatten. En dan heb je mensen rondlopen die de ziekte niet zouden hebben, maar dat komt omdat er een fout zit in deze kant van het verhaal: ten onrechte is de prognose Nee, terwijl dit Ja had moeten zijn.

Alleen dit verhaal doet je afvragen, waar beginnen we aan? Maar goed zo gaat het in het dagelijks leven ook. Je denkt dat iets niet klopt, maar het klopt wel, of je vertrouwt iets dat je beter niet had kunnen vertrouwen.

In het voorbeeld van - Snake Oil - gaat het o.a. over de bias van etnische minderheden die ten onrechte in de verkeerde (foute voorspelling) terecht komen. Deze minderheden worden door profileringssoftware met Ai onterecht gekwalificeerd.

Dat mensen een bias hebben in hun denken is sinds behavioral psychology bekend. Het probleem nu lijkt mij ook, is dat die bias nu systematisch gaat worden. We laten onze intelligentie nu over aan een stel van die Aigents en die maken dus fouten. Systematisch gaat dat dus fout.

Dat is mijn visie. Met de kennis van nu.

Er gaat natuurlijk ook heel veel goed, laten we dat niet vergeten...

* - Snake Oil (AI Snake Oil: What Artificial Intelligence Can Do, What It Can’t, and How to Tell the Difference, Arvind Narayanan, Sayash Kapoor), cover:

* - Snake Oil (AI Snake Oil: What Artificial Intelligence Can Do, What It Can’t, and How to Tell the Difference, Arvind Narayanan, Sayash Kapoor), cover:

Verward over AI en zich zorgen maken over wat het betekent voor uw toekomst en de toekomst van de wereld? Je bent niet alleen. AI is overal - en weinig dingen zijn omgeven door zoveel hype, verkeerde informatie en misverstand. In AI Snake Oil snijden computerwetenschappers ... door de verwarring om je een essentieel begrip te geven van hoe AI werkt en waarom het vaak niet is, waar het nuttig of schadelijk kan zijn, en wanneer je moet vermoeden dat bedrijven AI -hype gebruiken om AI -slangolie te verkopen - produceren die niet werken en waarschijnlijk nooit.

Hoewel het potentieel van sommige AI, zoals Chatgpt, erkent, ontdekt AI Snake Oil ongebreidelde misleidende beweringen over de mogelijkheden van AI en beschrijft de serieuze schade die AI al veroorzaakt in hoe het wordt gebouwd, op de markt gebracht en gebruikt in gebieden zoals onderwijs, geneeskunde, medicijnen, medicijnen, medicijnen, aanwerving, bankieren, verzekeringen en criminele rechtvaardigheid. Het boek legt de cruciale verschillen uit tussen soorten AI, waarom organisaties vallen voor AI Snake Oil, waarom AI sociale media niet kan repareren, waarom AI geen existentieel risico is en waarom we veel meer zorgen zouden moeten maken over wat mensen met AI zullen doen dan over alles wat AI zal doen. Het boek waarschuwt ook voor de gevaren van een wereld waar AI nog steeds wordt gecontroleerd door grotendeels onverklaarbare grote technologiebedrijven.

Door AI's limieten en echte risico's te onthullen, zal AI Snake Oil u helpen betere beslissingen te nemen over de vraag of en hoe u AI kunt gebruiken op het werk en thuis.

-- 20 januari 2026

- Filosoof Anco Peeters trapt op de rem: ‘Kijk uit met AI in het onderwijs’

Reacties